인공지능은 무엇이 되려 하는가

1️⃣ 한줄 평

한번도 실망시키지 않은 브록만 씨.

♓ Inuit Points ★★★★☆

시대의 변경에서 고민하는 지식인 25인에게 묻습니다. AI가 인류에게 미칠 임팩트는 뭐냐고. 하지만 단순히 열린 질문이 아니고, 속박된 물음을 던집니다. 노버트 위너의 사이버네틱스를 기준으로 각자 생각을 요청합니다. 이게 결정적 장점이 됩니다. 논의가 다양하면서도 균질적인 지향이 있습니다. 형식만으로도 이미 훌륭한데, 참여한 지식인들의 담론의 깊이 또한 만만치 않습니다. 별 넷 주었습니다.

❤️ To whom it matters

- AI에 대해 막연한 환상이나 두려움을 가진 분

🎢 Stories Related

- 인문, 과학, 예술하는 사람들을 한자리에 모아두고 콜로세움을 여는 브록만 씨입니다.

- 이번 25인 이야기를 그러모으는 방법이 특기할만 합니다.

- 노버트 위너는 사이버네틱스(cybernetics)의 주창자인데, 위너 없는 위너 헌정 논쟁집이 되었습니다.

- 사이버네틱스는, 어떤 초지능적 존재가 나올때 엘리트 인간이 이를 이용해 지구를 멸망케 할 수 있다는 주장입니다.

- 세계대전을 연이어 치룬 후, 핵폭탄마저 개발해, 인류가 멸망 직전이라는 음울한 세계관에 강한 영향을 받은 사조입니다.

- 흔히 쓰는 사이버(cyber)가 위너의 사이버네틱스에서 나온 말입니다.

- 사이버(cyber)는 카이버, 키로 조종한다는 뜻이고 govern의 어원입니다

- 존 매커시는 사이버네틱스란 말을 엄청 싫어해서, 새로 만든 조어가 인공 지능(artificail intelligence)입니다.

Possible Minds: 25 ways of looking at AI

John Brockman +25, 2019

🗨️ 좀 더 자세한 이야기

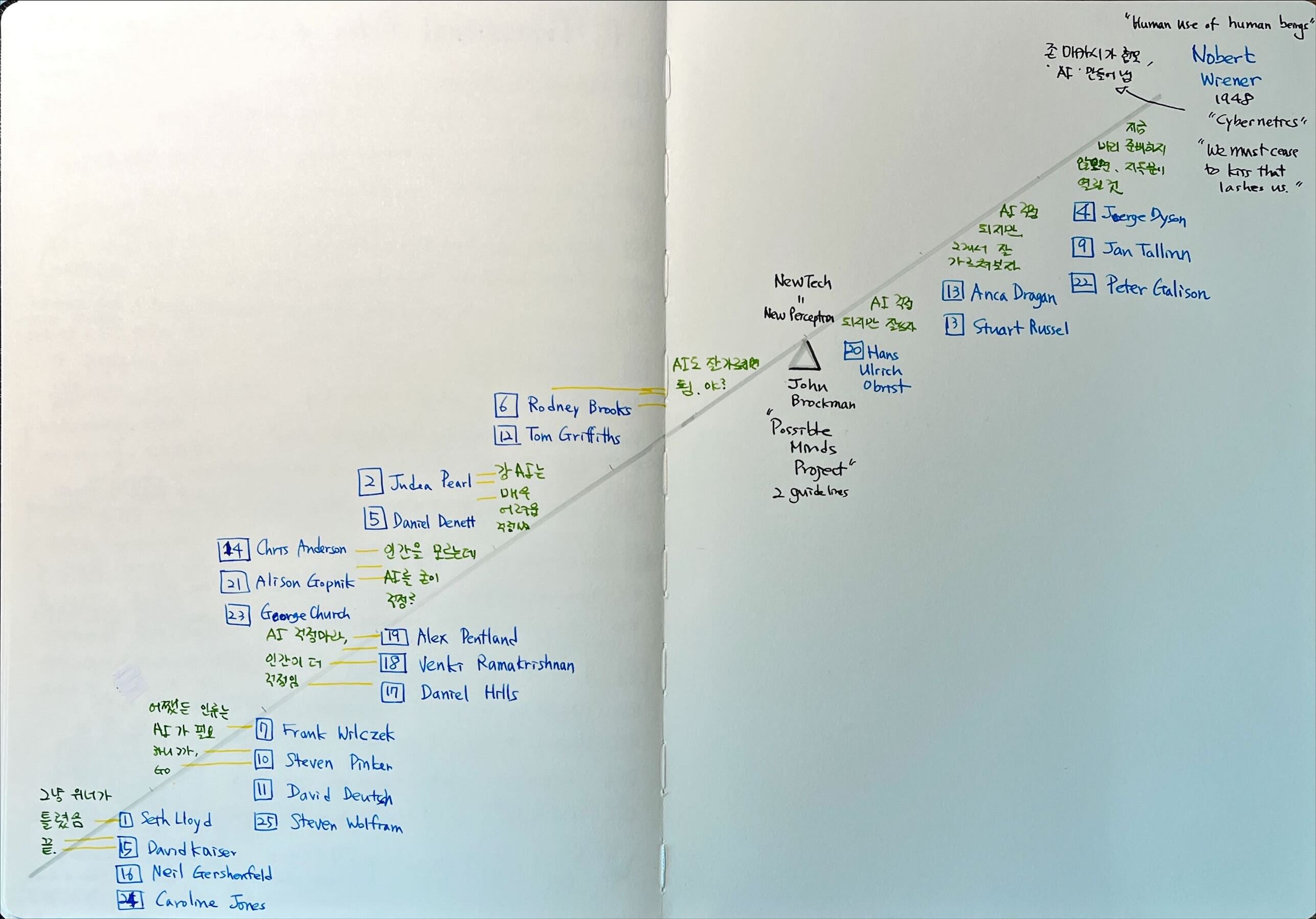

따라서 각 저자들은 대놓고 또는 암묵적으로 스탠스를 정합니다.

위너가 옳아 우린 망할거야 vs 위너 예측은 틀릴거임

저도 궁금해서 책을 다 읽고 줄을 세워 봤는데 의외였습니다.

책 읽는 도중엔 찬반이 반반 정도로 팽팽하다 여겼습니다. 매핑해보니 압도적으로 위너 반대편이 많네요. 종류도 좀 묶어봤습니다.

위너는 기술적으로 틀렸다 파

어차피 위너 시대에 지금 인공지능을 예측할 수도 없었거니와, 바로 뒤에 올 컴퓨터조차 제대로 예측하지 못했다. 그의 말은 시적이고 상상력을 자아내게 했을 뿐, 글자대로 해석하는건 무리다. 심지어 당대의 섀넌 이론도 이해하지 못한 말이다. 정보는 엔트로피일 뿐 의미가 아니다.

어쨌든 인류는 AI가 필요해 파

인간의 합리성을 믿을 필요가 있다. 결국 방법을 찾아낼 것이다 (윌첵)

굳이 인간의 힘을 저평가 할 필요 없다. 진짜 위험은 저런 과대망상 때문에, 과학이 가볼 수 있는 기술영역을 미리 재단하고, 상상을 제한하는 것이다. (핑커)

Gradient descent 방법을 쓰는 한, 인공지능은 국부 최적화를 할 것이다. 전역 최적화는 인간의 몫이다. (앤더슨)

인간도 인간을 모르는데 인공지능에 어떻게 모델링을 하겠는가 파

전문가의 추론 시스템은 오히려 학습시키기가 쉽지만, 몇 개의 샘플로 세계의 인지모델을 구축하는(heuristic) 4살 유아의 능력은 인공지능으로 코딩하기 어렵다(마음이론 창안자 고프닉)

인간보다 인공지능이 더 공정하고 합리적일 수 있음 (처치)

위너에 동조하는, AI 반대 편입니다 (강성순)

위너 말이 맞아. 우린 망할거야 파

AGI가 자기복제하는 순간 우린 하부화 될 것. 아날로그 컴퓨팅이 그 단초다 (다이슨)

초지능 반대는 소련의 반체제 운동과 닮았다. 지금은 소수지만 언젠간 우리가 이기리라. AGI의 문제는 노동을 종식하는 차원이 아니라 환경을 망가뜨리는 것 (탈린)

AGI 문제는 악의를 염려하는게 아니라 그 성능이다. 공포장사가 아니라 안전공학 차원에서 제한을 미리 넣어두자(테그마크)

AI가 걱정되지만 잘 가르치면 괜찮을지도 파

기계보상에 답이 있다 (러셀)

대략 이런데, 위너의 생각을 계승한 학자들이 우려하는 건 가치정렬(value alignment)입니다.

첫째는 원숭이 발 문제 또는 미다스의 손 문제입니다. 시키는 것만 문자그대로 완수하여, 부작용이 문제가 되는 상황입니다. 암치료제를 찾는다고 인류를 대상으로 생체실험을 해버린다든지, 바다 산성을 낮추는 대신 대기를 망쳐놓는다든지입니다.

둘째는 영화적 공포입니다. 더 심화해서 AI가 자체의 욕망대로 움직이는 경우지요. 종이 클립 이슈라고 불립니다. 만일 종이 클립이 AI 기계 시스템의 입맛에 맞다고 치면, 문물을 관장하는 AI서버가 온 바다를 종이클립으로 메우지 않을 이유가 있을까 하는겁니다.

이에 대한 반론은 세가지 같습니다.

- 그렇게까지 기술을 발전시키기 쉽지 않다.

- 사람 모델링도 안되어 있으니, 종합적 인지모델 자체를 만들기 어렵다

- 어쨌든 사람 가르치듯 가르치면 된다

결국 AI 학습은 양육개념이라고 보면 더 잘 이해됩니다. 사람 아이도 잘 가르치기 어려운데, AI라고 쉽게 가르칠수 있겠습니까. 양자컴퓨팅을 만든 도이치는 진정한 AGI는 체스를 매번 이기도록 만든 때가 아니라 체스를 이기지 않기로 결정하는 능력이 생길 때라고 봅니다.

여기에 따라 나오는 개념이 자유의지입니다. 보상과 처벌을 내면화한 결과라고 생각할 수 있습니다. 자유의지는 윤리와 맞닿아 있고요.

결국 울프람 말처럼, 인간 고유의 능력은 목적(purpose)입니다. 목적을 가질 때 가치가 생기고 동기가 생깁니다 목적은 희소성의 바다에서 생기는 목마름 같은 결핍일 겁니다. 이걸 인공지능이 어떻게 내포할지가 지켜볼 포인트 같습니다.

다 읽고난 제 느낌은 사실 위너의 말은 시적이거나 은유적으로 보는게 맞겠습니다. 다만 위너는 메기입니다. 그의 상상 덕에 우린 다양한 걱정을 미리, 치열히 할 수 있어 좋습니다. 위너파에서 펼치는 주장도 일리가 있습니다. 이미 정부나 기업은 하이브리드 초지능의 성격을 띕니다. 엘리트 집단은 기술을 써서 통제를 강화해 나가고 있다고 보는거죠.

따라서 강AI의 문제는 지극히 철학적 담론을 깔아야합니다. 우리나라 학계도 이렇게 통섭적으로 접근하면 좋겠습니다.